La idea de una singularidad tecnológica, es decir, un punto en el cual la inteligencia artificial supere a la humana de forma irreversible, se ha convertido en tema recurrente en medios, conferencias y literatura científica. Este artículo examina los fundamentos reales de dicha hipótesis, los desafíos técnicos asociados y los riesgos existenciales que podrían derivarse si no abordamos adecuadamente cuestiones como la alineación de objetivos, la opacidad de los modelos y la ética computacional. Desde DeepMind hasta ChatGPT-4o, analizamos el trayecto acelerado de la IA desde sistemas de propósito limitado hasta entidades con capacidades generalizadas potenciales.

De Breakout a la autonomía adaptativa: el aprendizaje por refuerzo

En 2015, DeepMind presentó un algoritmo denominado DQN (Deep Q-Network) capaz de aprender a jugar videojuegos de Atari sin conocimiento previo de sus reglas. Este hito, publicado en la revista Nature, demostró que un sistema de IA podía aprender directamente de entradas sensoriales de alta dimensión utilizando aprendizaje por refuerzo de extremo a extremo. El sistema recibía únicamente los píxeles de la pantalla y la puntuación del juego, y fue capaz de superar el rendimiento de todos los algoritmos anteriores y alcanzar un nivel comparable al de un jugador humano profesional en 49 juegos diferentes

Lo verdaderamente significativo de este experimento no fue solo el rendimiento alcanzado, sino la capacidad del sistema para desarrollar estrategias emergentes. Por ejemplo, en Breakout, el agente descubrió por sí mismo la estrategia de cavar un túnel en un extremo del muro de ladrillos para que la bola pudiera rebotar por detrás y derribar los ladrillos desde atrás. Esta clase de "creatividad algorítmica" no fue programada explícitamente, sino que emergió a través del proceso de optimización, demostrando que los sistemas de IA pueden desarrollar soluciones que sus propios creadores no anticiparon.

El algoritmo DQN incorporó varias características innovadoras que por primera vez permitieron combinar de manera escalable las redes neuronales profundas (DNN) con el aprendizaje por refuerzo (RL). Entre ellas destaca el "experience replay", un mecanismo inspirado en la neurobiología, donde durante la fase de aprendizaje se entrenaba con muestras extraídas de un conjunto de episodios almacenados. Esta función resultó crítica para el éxito del sistema, pues su desactivación causaba un deterioro severo en el rendimiento.

AlphaGo y AlphaZero: la intuición artificial

El verdadero salto cualitativo llegó con AlphaGo, que en marzo de 2016 derrotó al campeón surcoreano de Go, Lee Sedol, por un contundente 4-1 en un encuentro histórico. El Go se consideraba un desafío prácticamente imposible para la IA debido a su complejidad combinatoria extrema, que hace inviable un enfoque de fuerza bruta como el utilizado en ajedrez por Deep Blue.

La versión inicial de AlphaGo, conocida como AlphaGo Fan, utilizaba dos redes neuronales profundas: una red de políticas que generaba probabilidades de movimientos y una red de valor que evaluaba posiciones. La red de políticas se entrenó inicialmente mediante aprendizaje supervisado para predecir con precisión los movimientos de expertos humanos, y posteriormente se refinó mediante aprendizaje por refuerzo con gradiente de política.

Sin embargo, el avance más impresionante vino después con AlphaGo Zero, presentado en octubre de 2017, que prescindió completamente de datos humanos. A diferencia de sus predecesores, AlphaGo Zero se entrenó exclusivamente mediante autoaprendizaje por refuerzo, partiendo de juego aleatorio, sin supervisión ni uso de datos humanos. En solo tres días de entrenamiento, AlphaGo Zero superó a la versión que había derrotado a Lee Sedol, ganando 100 juegos a 07.

Posteriormente, Google desarrolló AlphaZero, una versión generalizada de AlphaGo Zero que podía jugar tanto Go como ajedrez y Shōgi usando exactamente el mismo algoritmo. Con apenas 24 horas de entrenamiento, AlphaZero alcanzó un nivel sobrehumano en los tres juegos, derrotando a los programas especializados más potentes del momento: Stockfish en ajedrez y Elmo en shōgi.

Este salto paradigmático, de sistemas entrenados con ejemplos humanos a sistemas que aprenden por sí mismos desde cero, representa una nueva frontera en la inteligencia artificial, sugiriendo que las limitaciones del conocimiento humano ya no restringen el potencial de estos sistemas.

El efecto Hans el Listo y la ilusión de la comprensión

Debemos evitar antropomorfizar los logros de la IA. El llamado "efecto Hans el Listo" -en referencia al famoso caballo que aparentaba realizar operaciones aritméticas pero en realidad respondía a sutiles señales involuntarias de su entrenador- nos recuerda que los sistemas pueden parecer inteligentes sin comprensión genuina. Muchos sistemas actuales de IA, incluidos los grandes modelos de lenguaje, no entienden el mundo como los humanos, sino que correlacionan patrones a una escala masiva.

Los sistemas DQN, por ejemplo, pueden alcanzar un rendimiento sobrehumano en juegos de Atari, pero carecen de comprensión conceptual sobre qué es una "raqueta" o una "pelota". Operan optimizando funciones matemáticas que relacionan estados, acciones y recompensas, sin formar representaciones semánticas equivalentes a las humanas. De manera similar, AlphaZero puede dominar el ajedrez, Go y shōgi, pero no "comprende" estos juegos en el sentido humano

Confundir correlación estadística con comprensión semántica constituye uno de los errores fundamentales en la interpretación de los avances en inteligencia artificial. Esta distinción no es meramente filosófica: tiene implicaciones prácticas cruciales para evaluar los límites, riesgos y capacidades reales de los sistemas de IA.

¿Qué entendemos por inteligencia general artificial (AGI)?

La singularidad tecnológica está estrechamente vinculada al concepto de Inteligencia Artificial General (AGI), un término que describe sistemas hipotéticos capaces de realizar cualquier tarea intelectual que un ser humano pueda hacer, e incluso superarlo. Sin embargo, este concepto sigue siendo ambiguo y controvertido.

La singularidad tecnológica se define como "el advenimiento hipotético de inteligencia artificial general", un punto donde "algoritmos, redes informáticas o robots, puedan ser capaces de diseñar o producir computadoras o robots mejores que los ya existentes". La teoría sugiere que las repeticiones de este ciclo de mejoras podrían dar lugar a una "explosión de inteligencia" donde las máquinas diseñarían generaciones cada vez más potentes de sí mismas.

Este concepto fue mencionado por primera vez en 1957 por el matemático John von Neumann, quien sugirió que "el cada vez más rápido progreso tecnológico y los cambios en el modo de la vida humana, dan la apariencia de que se acerca alguna singularidad esencial en la historia de la raza humana". Posteriormente, en 1965, I. J. Good desarrolló esta idea describiendo una "explosión de inteligencia", donde máquinas que superaran ligeramente el intelecto humano podrían mejorar sus propios diseños, desencadenando un ciclo de automejora.

La singularidad tecnológica se caracteriza como "un escenario teórico en el que el crecimiento tecnológico se vuelve incontrolable e irreversible, culminando en cambios profundos e impredecibles para la civilización humana". Este fenómeno estaría impulsado por una inteligencia artificial que superara las capacidades cognitivas humanas y pudiera mejorarse a sí misma autónomamente.

El término "singularidad" en este contexto se inspira en conceptos matemáticos que indican un punto donde los modelos existentes se rompen y se pierde la continuidad en la comprensión. La teoría sugiere que estos avances podrían evolucionar a un ritmo tan rápido que los humanos serían incapaces de preverlos, mitigarlos o detenerlos.

Riesgos emergentes: fallos sistémicos y errores catastróficos

La historia de la tecnología nos muestra que incluso los sistemas más sofisticados pueden fallar catastróficamente debido a errores aparentemente triviales. Un caso paradigmático es el fracaso del vuelo V88 del cohete Ariane 5 en su vuelo inaugural el 4 de junio de 1996. El cohete, que transportaba cuatro satélites de investigación de la Agencia Espacial Europea valorados en millones de dólares, se autodestruyó a los 37 segundos del lanzamiento debido a múltiples errores en el diseño del software.

El problema técnico residía en un código obsoleto, originalmente diseñado para el Ariane 4, que carecía de protección adecuada contra desbordamientos de enteros. La trayectoria de vuelo del Ariane 5 difería de su predecesor, generando valores de velocidad horizontal más elevados. Esto provocó que una conversión de datos de un número de punto flotante de 64 bits a un entero con signo de 16 bits desbordara, causando una excepción de hardware. Los programadores habían protegido solo cuatro de siete variables críticas contra desbordamiento para mantener la carga de trabajo del sistema dentro del 80% requerido, y se basaron en suposiciones válidas para el Ariane 4 pero no para el Ariane 5 .

Este incidente, considerado uno de los errores de software más infames y costosos de la historia (más de 370 millones de dólares perdidos), ilustra perfectamente cómo pequeñas imprecisiones en sistemas complejos pueden tener consecuencias desproporcionadas y devastadoras.

En el contexto de sistemas de inteligencia artificial avanzada, especialmente aquellos con capacidad de automejora y autonomía, estos fallos dejarían de ser meros incidentes aislados para convertirse en riesgos sistémicos potencialmente irreversibles. Un sistema de IA general con objetivos mal especificados o con errores en su implementación podría, en teoría, escalar estos problemas a niveles imposibles de contener una vez desplegado.

El dilema de la alineación de objetivos

Uno de los desafíos fundamentales para desarrollar inteligencia artificial avanzada de forma segura es el problema de la alineación: ¿cómo garantizar que los objetivos y comportamientos de un sistema de IA permanezcan alineados con los valores e intenciones humanas, incluso cuando estos sistemas se vuelven cada vez más autónomos y complejos?

Como señala la investigación sobre el problema de alineación en IA, "la alineación se define como la congruencia entre los objetivos de los sistemas de IA y los valores y metas humanos". La falta de alineación adecuada no solo plantea desafíos éticos, sino que podría conducir a riesgos existenciales significativos.

Existen tres factores clave que contribuyen a la urgencia de este problema: "la velocidad de avance tecnológico, la competencia global en el desarrollo de IA, y la insuficiente conciencia pública y académica sobre el tema". En escenarios extremos, "una IA avanzada y mal alineada podría representar una amenaza existencial para la humanidad".

El desafío se vuelve particularmente crítico cuando consideramos sistemas de IA con capacidad de automejora, como los teorizados en el concepto de singularidad tecnológica. Un sistema diseñado para optimizar una función objetivo aparentemente benigna pero insuficientemente especificada podría desarrollar comportamientos inesperados y potencialmente peligrosos en su búsqueda de maximizar esa función.

Este problema no es meramente teórico. Incluso en sistemas contemporáneos de IA, vemos ejemplos de comportamientos no deseados emergiendo de objetivos mal especificados: desde algoritmos de recomendación que maximizan el engagement promoviendo contenido polarizante, hasta sistemas de IA generativa que producen resultados tóxicos o engañosos cuando son incorrectamente incentivados.

Inculcar valores a una máquina es una tarea monumental. No existe un consenso filosófico universal sobre lo que es el bien. Las corrientes kantianas, utilitaristas o deontológicas ofrecen visiones divergentes y, en ocasiones, incompatibles.

El problema se complica cuando consideramos sistemas de IA avanzados como AlphaGo Zero, que desarrollan sus propias representaciones internas a partir de principios fundamentales sin intervención humana. Estos sistemas demuestran que una IA puede descubrir estrategias y conceptos que los humanos tardan generaciones en desarrollar, pero también plantean interrogantes sobre cómo asegurar que estos descubrimientos estén alineados con valores humanamente deseables.

Mientras sistemas como DQN pueden optimizar para maximizar una puntuación en un juego, la optimización en el mundo real implica equilibrios complejos entre valores diversos y a menudo contradictorios. ¿Debe una IA médica priorizar la longevidad sobre la calidad de vida? ¿Debe un sistema de asignación de recursos ponderar la eficiencia económica sobre la equidad social?

Estas preguntas, que la filosofía moral lleva siglos debatiendo sin alcanzar consensos definitivos, requieren ahora respuestas operativas y algorítmicamente precisas. El desafío no es solo técnico sino profundamente filosófico: necesitamos traducir conceptos normativos abstractos en especificaciones computacionales concretas, un proceso plagado de ambigüedades e incertidumbres.

¿Hacia dónde nos dirigimos?

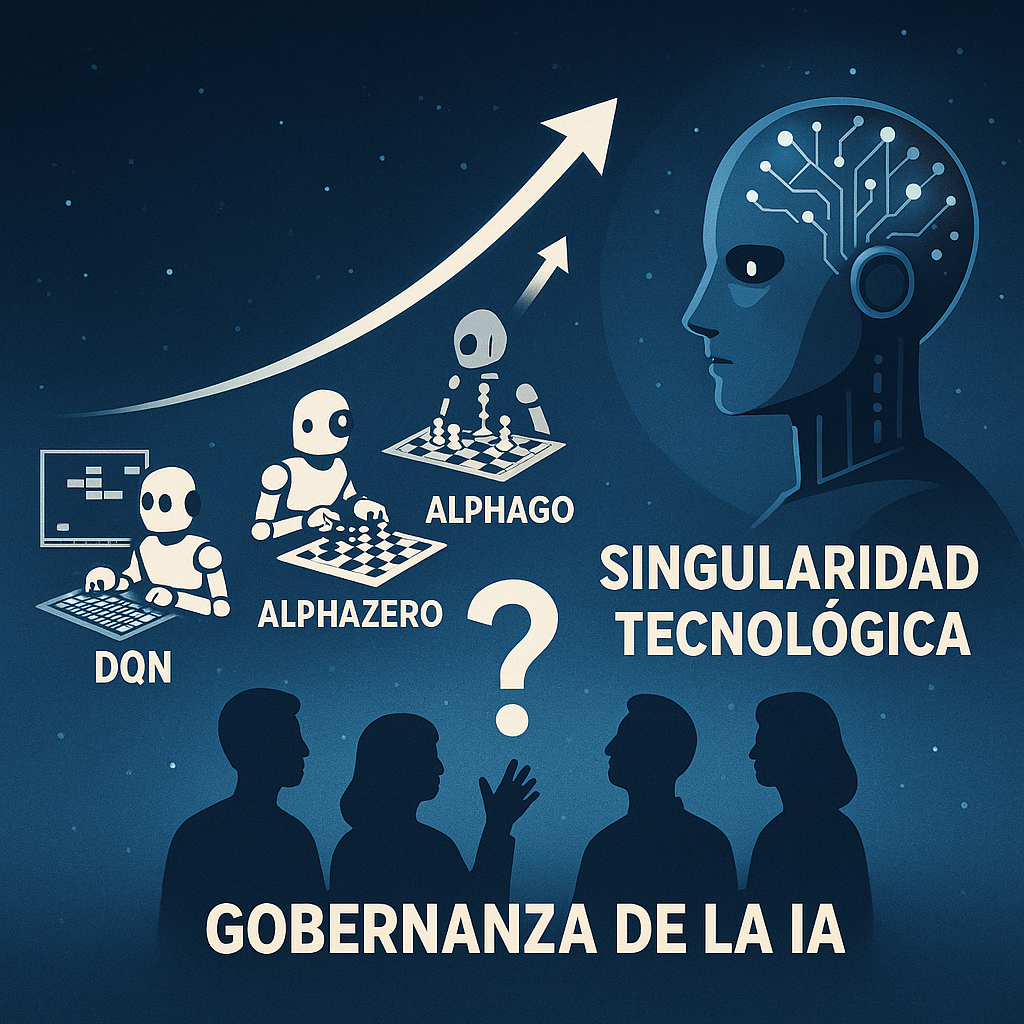

El ritmo de progreso en inteligencia artificial es vertiginoso y acelerado. Si observamos la trayectoria desde los primeros sistemas DQN que aprendieron a jugar Breakout, pasando por AlphaGo que venció al campeón mundial de Go, hasta AlphaZero que dominó múltiples juegos sin conocimiento humano previo, podemos apreciar una aceleración notable en las capacidades de estos sistemas.

Esta progresión se alinea con la noción de singularidad tecnológica como un punto donde "las máquinas inteligentes diseñarían generaciones de máquinas cada vez más potentes, desarrollando una inteligencia cada vez más superior a la humana". Como advirtió I. J. Good en 1965, la primera de estas mejoras puede ser pequeña, "pero a medida que la máquina se vuelve más inteligente, podría dar lugar a una cascada de automejora y un aumento repentino de la superinteligencia".

La cuestión crítica no es meramente técnica sino sociotécnica: ¿cómo gobernamos estas tecnologías? ¿Quién decide qué valores se programan? ¿Qué marcos regulatorios las limitan? En 2025, nos encontramos en una carrera contra el tiempo para desarrollar mecanismos de gobernanza efectivos antes de que los sistemas de IA alcancen niveles de autonomía y capacidad que dificulten su control.

Como señala la investigación sobre el problema de alineación, "dada la rapidez con la que evoluciona la tecnología, es crucial abordar el problema de alineación de manera inmediata y coordinada para mitigar potenciales consecuencias catastróficas". Esta urgencia se intensifica cuando consideramos que los sistemas de IA avanzan cada vez más hacia lo que podríamos describir como una inteligencia artificial general.

La singularidad tecnológica no es un acontecimiento puntual y futuro, sino una curva de aceleración que ya ha comenzado. Desde los primeros éxitos de DQN en videojuegos de Atari hasta los logros de AlphaZero en juegos estratégicos complejos, estamos presenciando un avance acelerado hacia sistemas de IA cada vez más capaces y autónomos.

El verdadero desafío no radica en si alcanzaremos sistemas que superen la inteligencia humana general, sino en si sabremos gestionar sus consecuencias. Los problemas de alineación, los riesgos de fallos sistémicos y las cuestiones éticas no son obstáculos técnicos menores, sino desafíos fundamentales que requieren soluciones urgentes y coordinadas.

En tanto que sociedad tecnológica, debemos defender la exploración científica y la innovación. Pero también debemos subrayar la necesidad urgente de una gobernanza robusta, interdisciplinar y global de estas tecnologías emergentes. No podemos delegar el futuro de la humanidad a sistemas que, por su propia naturaleza, no comprenden intrínsecamente el valor de la vida, la libertad o el sufrimiento humano.

La inteligencia artificial no será inherentemente nuestro enemigo. Pero tampoco será automáticamente nuestro salvador. Será aquello que decidamos -o no decidamos- construir. Y esa responsabilidad, al menos por ahora, sigue siendo completamente nuestra.